X 旧Twitterはこちら。

https://twitter.com/ison1232

************

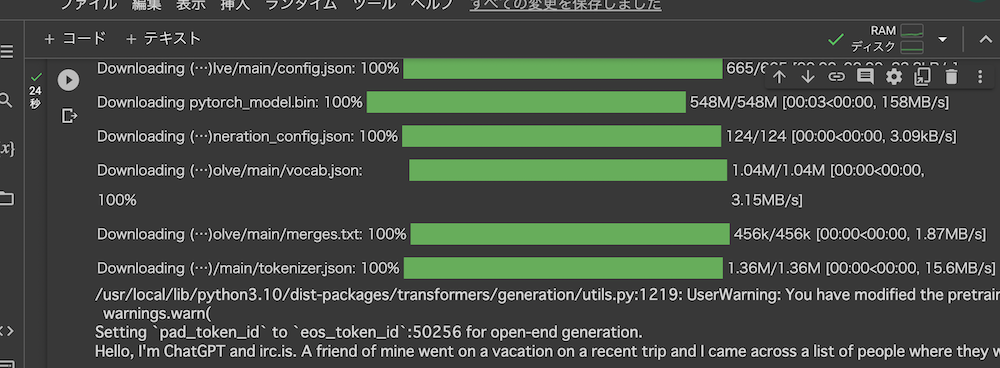

大規模言語モデル ELYZA-japanese-Llama-2-7b-instructを使ってみた

東大 松尾研出身のAIベンチャー「ELYZA」が開発した

ELYZA-japanese-Llama-2-7b-instruct

をインストして使ってみました。

llama2をベースに日本語を事前学習させたモデルらしい。

商用利用可能なので、そこがいいですね。

instructって名前に付いているので、instruct tuningしてるやつですね。

instruct tyningとは、質問に指示を与えて、それについてのタスクの実行を答えさせるやつです。

通常の質問応答タスクと違って、汎用性があるというか、未知の解答にも答えられるようになるらしいです。

これからのファインチューニングの主流になるんですかね。

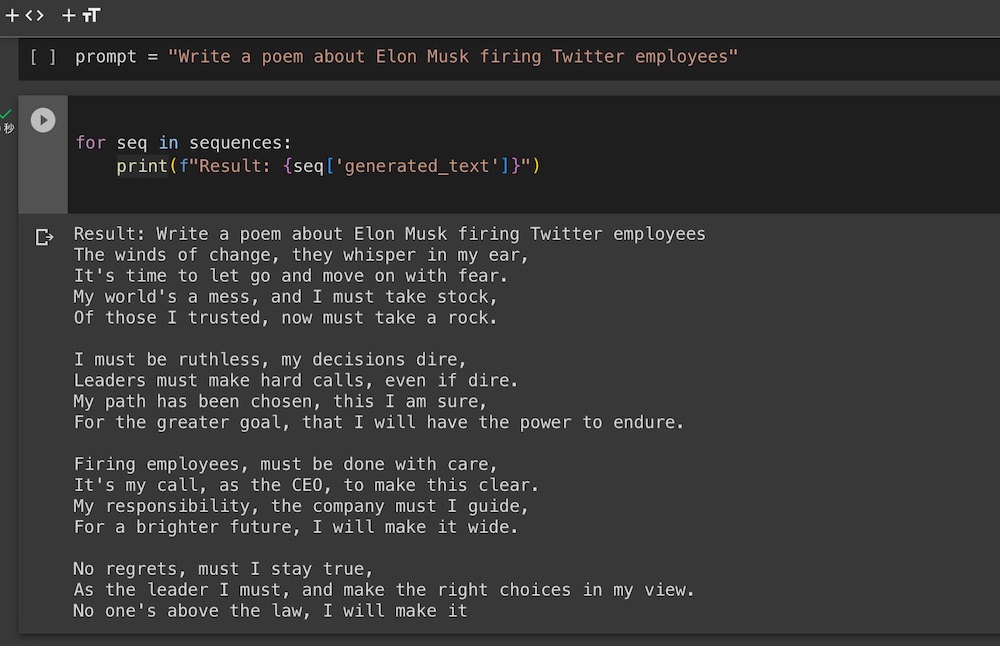

プロンプトと応答文をGPT-4に作ってもらう。

以下、質問と応答を載せます。

ちなみに、質問(プロンプト)はGPT-4に作ってもらったものです。

なんでもLLMの性能評価にいいらしいです。

応答に関しては比較のために、ELYZAとGPT-4の応答文を載せてみました。

まあ、パラメータ数が圧倒的に違いますから、GPT-4の方が優勢ですが、そこはねえ。

ELYZAはフリーで商用利用可ですから、それも魅力のひとつでしょう。

では、質問と応答をどうぞ。

プロンプト:時間とは何ですか?それはどのように私たちの生活や認識に影響を与えますか?

●時間とは何ですか?それはどのように私たちの生活や認識に影響を与えますか?

ELYZA応答

時間とは、ある事象が起こるまでの間隔のことを指します。たとえば、ある物体が光の速度で移動する際には、その物体の位置から観測者の位置へと時間的な流れとともに情報が伝わります。

また、時間は空間とともに万有引力の法則によって定められた、宇宙の普遍的な構造でもあります。

時間は私たちの生活や認識に大きな影響を与えています。例えば、時計は時間を測定することで私たちの生活を調整し、時間を予測することで計画を立てるのに役立ちます。また、時間は記憶の構造化や、過去と未来の概念を定義する上で重要な役割を果たしています。

GPT-4応答

時間は、出来事が発生する順序や間隔を測定するための抽象的な概念であり、物理的な宇宙の基本的な次元の一部としても理解されています。この概念は、人類の歴史を通じてさまざまな文化や哲学において探求されてきました。時間は、日常のスケジュールの計画から、科学的な実験の実施、歴史の研究に至るまで、あらゆる活動の中心に位置しています。

私たちの生活における時間の影響は計り知れないものがあります。それは私たちが行う一つ一つの活動、過去を回顧す

プロンプト:2150年の未来都市について、短い物語を書いてください

●2150年の未来都市について、短い物語を書いてください。

ELYZA応答

2150年の未来都市は、高層ビルが立ち並ぶ街並みとは裏腹に、豊かな自然が溢れていた。

その街の中心には、巨大なオブジェクトが存在した。それは、昔々人間が作ったという、廃墟の城だった。

その城の周りには、様々な動植物が生息していた。その中には、人間の手によって改良された動植物もいた。

その街に住む人々は、その城を訪れる人が増えることを望んでいた。

その頃、城の調査をしていた一団が、珍しい植物を発見した。それは、人間の言葉を理解し、話すことができる植物だった。

彼らは、その植物を連れて帰ろうとしたが、その植物はそれを拒んだ。

「私はここにいたい。」

彼らは、その植物の言葉を受け入れ、そのまま城に残った。

その植物は、城の住民と共に暮らし始めた。彼らは、彼女に名前をつけ、彼女も彼らのことを呼んだ。

彼女の名前は、エルフィーナ。彼女は、城の住民の間で、彼らの話し相手となり、彼らの悩み

GPT-4応答

2150年、未来都市エクセリオンは空に浮かぶ巨大な都市として知られていた。地球の地表は自然に戻り、植物や動物たちが豊かに生息している。エクセリオンは透明なドームに囲まれ、高度なエネルギーシステムにより持続可能な生活が保たれていた。

アイラはエクセリオンで生まれ育った17歳の少女。彼女は都市の外の世界に憧れ、ある日ドローンで地表を探索することに決めた。アイラが操作するドローンは、彼女の瞳に映る映像と連動しており、彼女の心の動きに応じて飛行する。

ドローンを飛ばし始めると、アイラは美しい緑の森や青い湖を発見。かつて人々が住んでいたであろう廃墟も見える。アイラは驚くほどの自然の美しさと、かつての人々の生活の痕跡に心を奪われた。

しかし、彼女が最も心を打たれたのは、森の中に住む原住民の部族だった。彼らはシンプルで豊かな生活を送っており、アイラは彼らと共に数日を過ご

プロンプト:日本の伝統的な「おもてなし」文化を説明してください

●日本の伝統的な「おもてなし」文化を説明してください。

ELYZA応答

日本の伝統的な「おもてなし」文化を説明します。

日本のおもてなしは、お客さまに心からの感謝と祝福の気持ちを伝えることを目的としています。日本のおもてなしは、精神的なものであり、物理的なものではありません。

日本のおもてなしの特徴は、心からの感謝と祝福の気持ちを伝えることを目的としている点です。日本のおもてなしは、お客さまに対して心からの感謝と祝福の気持ちを伝えるための行動です。

日本のおもてなしの例としては、茶道や華道、着付けなどが挙げられます。日本のおもてなしは、心からの感謝と祝福の気持ちを伝えることを目的としているため、心のこもった行動が重要となります。

GPT-4応答

日本の伝統的な「おもてなし」文化は、相手の立場や気持ちを尊重し、細やかな心配りと気配りを行うことを中心にした接客の精神を指します。以下、主な特徴や背景を簡潔に説明します。

相手を尊重する: おもてなしの根底には、相手を尊重し、その心地よさを第一に考えるという思いやりがあります。

先読みの心配り: 相手が何を必要としているのか、何を望んでいるのかを先読みし、それを提供すること。例えば、訪れた客が喉を潤したそうにしている時、言われる前に水やお茶を出すなど。

細やかな気配り: 例として、季節に合わせた食材を使った料理の提供や、部屋の温度

今度は英語で答えてもらいます。

プロンプト:日本の伝統的な「おもてなし」文化を英語で説明してください

●日本の伝統的な「おもてなし」文化を英語で説明してください。

ELYZA応答

日本の伝統的な「おもてなし」文化を英語で説明します。

日本のおもてなしは、お客さんを心から歓迎し、心からのおもてなしをすることです。日本人はおもてなしの精神に従って、お客さんに心からの笑顔と感謝の気持ちを伝えます。おもてなしの中心は、お客さんの要望に応えることと、心からの笑顔です。日本のおもてなしは、心からの笑顔と感謝の気持ちを伝えることで、お客さんに満足してもらい、幸せな気持ちにします。

筆者談 英語で答えてないですねえ。

GPT-4応答

Certainly, here’s an explanation of Japan’s traditional “Omotenashi” culture in English:

“Omotenashi” is a Japanese term that captures the essence of traditional Japanese hospitality. It’s a concept deeply rooted in the country’s cultural fabric and reflects a commitment to providing impeccable service and genuine kindness without expecting anything in return. Key aspects of “Omotenashi” include:

Selfless Hospitality: At its core, “Omotenashi” means to wholeheartedly take care of guests without expecting any compensation or favor in return. It’s an authentic gesture of kindness and respect.

Anticipatory Service: It emphasizes understanding the needs of the guest even before they articulate them. This

筆者談: GPT-4は英語でバッチリ答えてます。

プロンプト:量子コンピュータとは何ですか?それは古典的なコンピュータとどのように異なりますか?

●量子コンピュータとは何ですか?それは古典的なコンピュータとどのように異なりますか?

ELYZA応答

量子コンピュータは、量子力学の原理を利用したコンピュータのことです。現在のコンピュータは、ビットと呼ばれる最小単位の情報を取り扱いますが、量子コンピュータでは、量子ビットと呼ばれる最小単位の情報を取り扱います。量子ビットは、クロックという量子力学の概念を用いて情報を扱うことができるため、現在のコンピュータよりも高速に処理を行うことができます。また、量子コンピュータはクロックの量子効果を利用して、現在のコンピュータでは計算できない問題も解決することが期待されています。

GPT-4応答

量子コンピュータは、量子力学の原理を利用して情報を処理する新しいタイプのコンピュータです。古典的なコンピュータとの主な違いは、情報の表現と処理方法にあります。

情報の表現:

古典的なコンピュータ: ビットを使用して情報を表現します。ビットは0または1の状態を持つことができます。

量子コンピュータ: 量子ビット、通常「キュビット」と呼ばれるものを使用します。キュビットは0、1の状態だけでなく、その2つの状態の重ね合わせを同時に持つことができます。

並列処理能力:

量子コンピュータは量子重ね合わせの性質を利用して、多数の計算を同時に行う能力があります。これにより、一部の問題に対しては古典的なコンピュータよりもはるかに高速に計算を行うことが可能です。

エンタングルメント:

量子コンピュータは「量子もつれ」という現象も利用します。これは2つ以上のキュビットが相互に関連付けられ、一方のキュビットの状態が変わると、もう一方のキュビットの状態も即座に

***********ここまで

大規模言語モデル ELYZA-japanese-Llama-2-7b-instructを使ってみたのまとめ

以上、大規模言語モデル ELYZA-japanese-Llama-2-7b-instructを使ってみました。

応答に関しては、ELYZAは通常の文章でまとめていきます。

一方、GPT-4は箇条書きにして段落ごとにまとめて応答していきますね。

詳しく知りたい時は、さらにその段落を攻めていけばいいと。

ベースとなったモデルのllama2の評判がいいですから、ELYZAも結構やりますね。

もっと大きいパラメータのモデルも作っているようで、今後が楽しみです。